Chega de "apagar incêndios": Como receber alertas automáticos antes que problemas nos dados do Google Analytics afetem suas vendas

Desafios de Data Quality na Análise de Dados do Google Analytics

Com o crescimento dos cenários de Big Data enfrentados pelas organizações devido ao crescente volume de dados gerados como resultado da coleta e mensuração para Marketing Digital e Offline em seus ambientes, análises de dados tornam-se cada vez mais complexas e difíceis de serem realizadas através de uma única ferramenta de mensuração, o que demanda integrações adicionais de dados para a criação de uma arquitetura de dados robusta e moderna, como um Data Lake e Data Warehouse, para que seja possível analisar dados de maneira personalizada e aderente a cada negócio, permitindo levar ferramentas como o Google Analytics (GA) para outro patamar na estratégia de Marketing.

E é neste contexto que entra o BigQuery: um Data Warehouse na nuvem do Google que foi construído para lidar com esse alto volume de dados, e que se integra perfeitamente com o Google Analytics.

O BigQuery é a ferramenta que permite que as equipes de Marketing e Dados armazenem e processem dados em grande escala, o que abre um universo de possibilidades, como automações inteligentes e implementação de mecanismos de validação de qualidade dos dados como criação de alertas quando alguma inconsistência é detectada nas bases de dados.

No universo de Big Data em Marketing Digital, normalmente nos deparamos com uma série de desafios relacionados à coleta eficiente de dados que reflitam corretamente a performance de campanhas de Marketing e a jornada end-to-end do usuário em websites e aplicativos, o que torna necessário adotar boas práticas de Data Quality que permitam detectar problemas de mensuração que possam afetar a veracidade dos dados no Google Analytics, assegurando a possibilidade de diagnósticos rápidos e correções antes que os problemas se transformem em verdadeiros “incêndios” que só são apagados quando a situação toma uma proporção muito maior.

O Google Analytics, por exemplo, conta com recursos de detecção de anomalias que alertam quando ocorrem problemas com os dados, e seu uso possibilita a obtenção de uma visão sobre a saúde da mensuração e coleta de dados, mas é possível adotar práticas que aprimoram mais ainda a validação de Data Quality em seus negócios com os dados armazenados em seu Data Warehouse, desbloqueando novas possibilidades de customização de acordo com suas necessidades.

Para ajudar a vencer estes desafios de Data Quality, a Google Cloud Platform (GCP) conta com uma ferramenta de Gestão de Governança de Dados chamada Dataplex Universal Catalog, que conta com uma série de serviços que permitem o gerenciamento, a descoberta e a padronização de artefatos de dados em nuvem.

Além disso, fornece uma série de soluções para descobrir o perfil e mensurar a qualidade dos dados armazenados tanto no BigQuery quanto em outros serviços do ecossistema da GCP, desbloqueando diversos insights sobre potenciais anomalias ou falhas em pipelines e processos de atualização, além de contar com sistemas de alarmística que detectam e reportam problemas ou ameaças relacionadas à qualidade dos dados.

Neste artigo, te ajudaremos a obter valiosas informações sobre qualidade de dados e a entender como uma ferramenta como o Dataplex Universal Catalog pode te auxiliar a ter um tempo de resposta muito menor a incidentes de mensuração de dados.

Como Funciona o Dataplex Universal Catalog?

O Dataplex Universal Catalog pode ser utilizado para criar verificações automatizáveis da qualidade dos dados armazenados no ambiente GCP, e cada verificação possibilita a configuração de um sistema de alarmística que dispara alertas via e-mail sempre que alguma anomalia é identificada, o que é especialmente útil para o estabelecimento de um processo tempestivo e proativo de identificação de problemas com os dados, possibilitando uma atuação mais ágil na correção destes problemas.

Com isso, podemos listar alguns cenários de uso do Dataplex Universal Catalog para a validação de Data Quality:

Alta volumetria de dados sendo processados e consumidos diariamente

O Dataplex Universal Catalog permite consultar dados diretamente do BigQuery ou do Google Cloud Storage, o que permite uma ampla gama de análises customizadas em cenários de alto volume de dados.

Coleta de dados fragmentada

Em contextos organizacionais onde a coleta de dados é implementada de maneira descentralizada, a detecção de anomalias com alto grau de detalhamento torna-se indispensável para identificar problemas de coleta de dados que possam estar atrelados a desafios de integração e padronização da coleta.

Alto impacto nos negócios por conta de anomalias na volumetria de dados de performance e comportamento do usuário

Em cenários de Marketing Digital complexos que empregam estratégias em múltiplos canais de Marketing, posicionadas para diferentes segmentos de usuários e disponíveis em várias plataformas online, detectar situações que fogem do padrão esperado de dados é essencial para efetuar correções na coleta de dados e até mesmo na configuração e otimização de campanhas.

Necessidade de fomento à cultura de acompanhamento diário dos indicadores de Marketing

A criação de verificações de qualidade de dados e configuração de sistemas de alarmística com o Dataplex auxilia na criação de uma rotina de monitoramento contínuo da evolução de métricas de performance e engajamento de usuários ao longo do tempo.

Cada verificação de dados no Dataplex Universal Catalog permite a criação de um conjunto de regras de validação, que são definidas de acordo com as necessidades do negócio.

Caso seja necessário validar se os dados de campanhas de Marketing em uma tabela apresentam valores duplicados, por exemplo, é possível criar uma solução que dispara um alerta sempre que este problema for detectado.

Outro caso de uso bastante interessante envolve a necessidade de acompanhamento diário da performance de campanhas com dados que alimentam relatórios gerenciais.

E se os dados do dia anterior, por alguma razão, não tiverem chegado aos relatórios? Para ajudar neste diagnóstico, é possível implementar uma regra que valida se os dados em uma tabela foram corretamente atualizados no dia anterior, auxiliando no endereçamento de correções ou reprocessamento de dados a equipes técnicas.

A seguir, mostraremos de maneira mais detalhada como o Dataplex Universal Catalog pode te auxiliar a tomar decisões mais rápidas quando algum problema afeta a performance e a veracidade dos seus dados de Marketing com base em uma série de perguntas que precisam ser feitas antes da sua implementação.

Quais Problemas Precisam ser Identificados?

O primeiro passo fundamental para que seja possível desenvolver um processo de detecção de anomalias nos dados do Google Analytics que são exportados para o ambiente GCP é entender quais regras de negócios devem ser consideradas durante a validação de qualidade de dados.

Caso a “dor” do negócio seja entender se os dados de uma tabela estão atualizados de acordo com a periodicidade esperada, então um campo de data presente em uma tabela torna-se o ponto central da verificação de qualidade de dados.

Já se a necessidade for detectar quedas bruscas na volumetria de sessões e leads nas jornadas de websites e aplicativos, então os valores dessas métricas serão os grandes balizadores da verificação de qualidade dos dados.

Ter este mapeamento claro é o que permitirá uma configuração de validação de Data Quality assertiva e alinhada aos objetivos do negócio.

Todos os Dados que Preciso Validar estão Disponíveis?

Uma boa prática que recomendamos adotar para tirar o melhor proveito do Dataplex Universal Catalog é a de criar tabelas especificamente preparadas para as verificações de qualidade de dados.

Vamos supor que queiramos validar se os dados que alimentam um relatório gerencial de Marketing foram atualizados dentro do período esperado, ou seja, se todos os dados estão disponíveis em até um dia anterior ao da consulta (D-1).

Nesta situação, podemos criar uma tabela que contém as dimensões de data, agrupamento de canal, origem, mídia e nome do evento do Google Analytics.

Este tipo de tabela poderá ser consumida pelo Dataplex Universal Catalog para identificar se, a nível de agrupamento de canal de Marketing, origem e mídia, os dados do Google Analytics estão corretamente atualizados.

Como Posso Personalizar minha Validação de Data Quality?

Com a tabela de consumo pronta para ser configurada com o Dataplex Universal Catalog, é possível dar início à construção da verificação de qualidade de dados de maneira personalizada para atender às necessidades de validação dos dados.

Algumas opções que o Dataplex Universal Catalog fornece para criar uma verificação da qualidade dos dados são:

Definição de Escopo

Define se, a cada verificação, todos os dados disponíveis deverão ser consultados ou se somente os dados mais recentes passarão pela validação, o que pode ser especialmente útil quando queremos entender o que está acontecendo com os novos dados que são gerados a cada dia.

Filtrar Dados

Permite aplicar alguns filtros às verificações de dados com base nas dimensões e métricas de negócios. Caso seja interessante validar somente dados de performance de campanhas cujo Agrupamento de Canal corresponda a um canal específico, é possível definir aplicar este critério como um filtro.

Programação de Rotinas

Permite definir uma recorrência para a verificação de qualidade de dados, podendo esta rodar a cada hora, a cada dia, semanalmente ou mensalmente.

Estas e algumas outras opções de personalização são fundamentais para criar uma validação de Data Quality eficaz e eficiente, sempre alinhada às “dores” do negócio.

Além das opções acima, a criação da verificação de qualidade de dados envolve a definição das regras ou critérios de validação mais detalhados que permitirão a identificação de problemas ou anomalias nos dados.

Seguindo o exemplo da configuração de uma verificação que avalia se os dados contendo os resultados mais recentes da performance de campanhas de Marketing foram atualizados dentro do período esperado, podemos criar uma regra que valida se os últimos registros inseridos no BigQuery ou no Google Cloud Storage foram atualizados em D-1.

Com isso, a regra consultará os dados disponíveis e verificará quantos destes dados estão realmente atualizados.

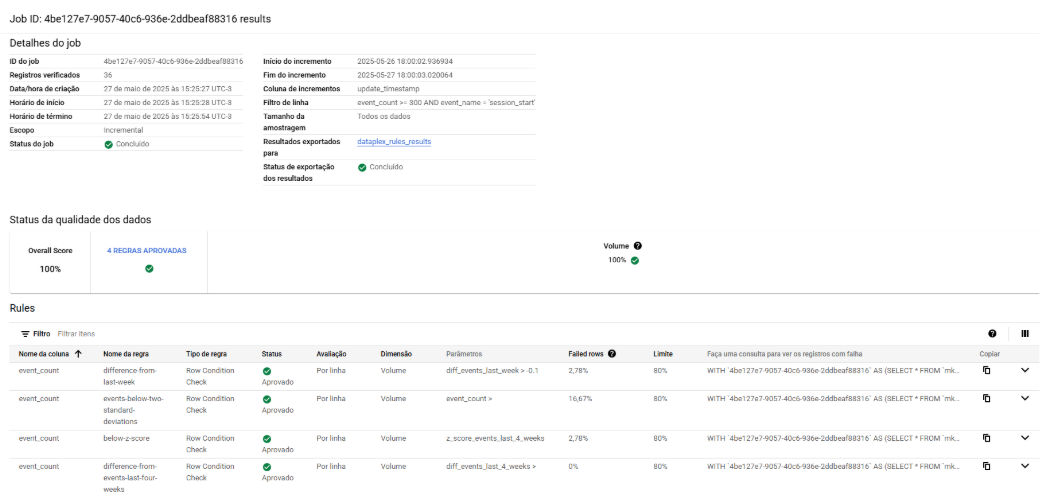

Abaixo, temos um exemplo de como o Dataplex exibe informações relacionadas aos jobs de verificação de qualidade de dados:

Quero saber os Resultados da Minha Validação de Data Quality. E Agora?

Após configurar a verificação de Data Quality no Dataplex Universal Catalog, é claro que queremos saber os resultados para entender se existe algum problema com os dados que exija atuação imediata.

Para isso, a ferramenta conta com a possibilidade de configurar um sistema de disparo automático de e-mails que alerta sempre que os critérios de validação não são atendidos na validação.

É possível fornecer até cinco endereços de e-mail que podem receber o relatório do Dataplex Universal Catalog, e é possível também definir em quais contextos estes alertas devem ser disparados, respondendo às seguintes perguntas: todos os meus dados disponíveis devem estar dentro do que eu espero em termos de Data Quality, ou há um limite mínimo aceitável onde eu já espero que meus dados não estejam 100% aderentes?

Ao responder a estas perguntas, basta publicar a verificação de Data Quality com o Dataplex Universal Catalog e começar a ter acesso a insights muito mais detalhados sobre a qualidade dos dados que você consome e reporta para a companhia.

Benefícios da Utilização do Dataplex Universal Catalog

O Dataplex Universal Catalog é uma ferramenta de gestão de ativos de dados e governança que abre uma gama de possibilidades de implementação de técnicas de mensuração de qualidade de dados e observabilidade, e diversos ganhos são esperados com a adoção das verificações de Data Quality, como:

- Maior confiabilidade no emprego dos dados em relatórios gerenciais e modelos de Machine Learning;

- Ganho de eficiência operacional, pois os alarmes do Dataplex podem ser configurados de modo a reportar anomalias de dados de maneira assertiva, reduzindo a necessidade de “caçar” onde está problema;

- Redução de riscos de conformidade, ao fornecer uma visão de quais dados devem ser corretamente tratados e quais anomalias precisam ser devidamente endereçadas para correção;

- Resposta mais rápida a incidentes, uma vez que os mecanismos de alarmística e observabilidade do Dataplex Universal Catalog podem fornecer insights de maneira rápida sobre potenciais problemas de coleta ou de usabilidade em websites e dispositivos móveis conectados ao Google Analytics ou Firebase.

Complementando o uso dos mecanismos de qualidade de dados do Google Analytics, o Dataplex Universal Catalog torna-se uma ferramenta muito útil para qualquer tipo de negócio que possua presença digital, descomplicando a adoção de uma cultura orientada a Data Quality e desbloqueando muitos insights que permitem alcançar maior confiabilidade na leitura dos dados de performance das suas campanhas e da jornada do cliente.

Na DP6, podemos te auxiliar no entendimento das suas necessidades de negócios e de análise e a implementar um sistema de Data Quality especialmente pensado para avaliar a qualidade dos seus dados de maneira ágil e eficaz.

Quer entender melhor como implementar o Dataplex Universal Catalog em seu negócio? Converse com um de nossos especialistas e eleve o nível dos seus dados com nossas soluções de Data Quality!